近年、AI技術の発展に伴い、より高度な計算能力が求められるようになりました。しかし、AIモデルの開発や運用には膨大な計算リソースが必要であり、その処理速度の向上が大きな課題となっています。

こうした課題を解決するために、Sakana AIが発表したのが「AI CUDA Engineer」です。この革新的な技術は、AI自身がGPUの計算処理を最適化することで、AIモデルの処理速度を大幅に向上させます。具体的には、従来の処理と比較して、10倍から100倍、場合によっては最大500%も処理速度を向上させることが可能です。

本記事では、「AI CUDA Engineer」の仕組みや、それがもたらす技術的なインパクトについて、専門知識がない方でも分かりやすいように解説していきます。

AI CUDA Engineerとは:AIをAIで高速化するエージェント

「AI CUDA Engineer」は、AI技術を活用してGPUのコード最適化を自動化し、計算速度を飛躍的に向上させるエージェントシステムです。この技術により、AIモデルの開発や利用時の処理速度が10〜100倍、場合によっては最大500%高速化されることが期待されています。

GPUとCUDAカーネルの最適化とは?

従来のAIモデルは、高度な計算処理を行うためにGPU(グラフィックス処理装置)の性能に依存しており、その最適化にはCUDAカーネル(GPUにデータの処理方法を教える「作業手順書」のようなもの)の調整が必要でした。しかし、CUDAカーネルの最適化は非常に高度な専門知識を要するため、熟練のエンジニアが手作業で調整する必要がありました。

一方、「AI CUDA Engineer」を活用すれば、この最適化プロセスが自動化され、より効率的なCUDAカーネルを生成できます。これにより、AIモデルの開発時間を短縮できるだけでなく、計算コストの削減や消費電力の抑制といったメリットも得られます。

AI CUDA Engineerの開発経緯:AI技術の進化と計算負荷の増大

近年、AI技術の発展に伴い、AIモデルの規模が急速に拡大しています。特に大規模言語モデル(LLM)のトレーニングや推論には膨大な計算リソースが必要であり、企業のコスト負担が増加しています。

こうした課題の解決に向け、Sakana AIは「AIの開発プロセスをAIで最適化する」というビジョンのもと、これまでに「AIサイエンティスト」(AI研究の自動化技術)や「LLM Squared」(LLMがLLMをトレーニングする手法)を開発してきました。

そして、次のステップとして、AIの処理速度そのものをAIで最適化する技術に挑戦したのが「AI CUDA Engineer」です。この技術の成功により、AIモデルの計算速度が飛躍的に向上し、企業のコスト削減や環境負荷の軽減にも貢献することが期待されています。

AI CUDA Engineerの仕組み

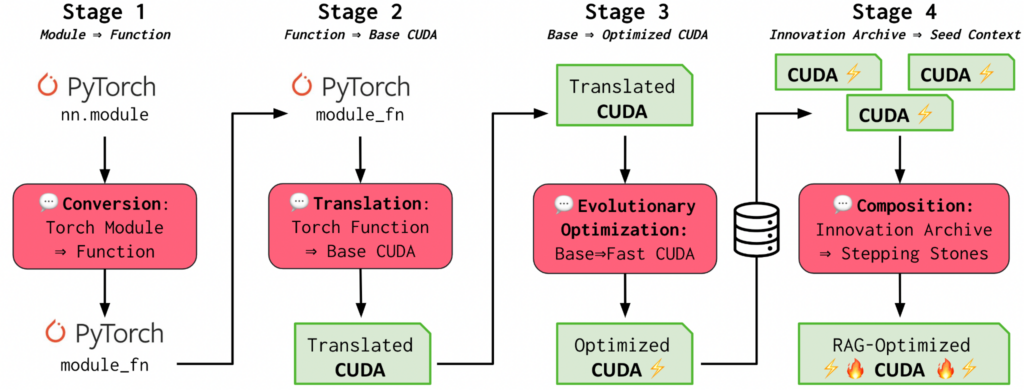

Sakana AIの「AI CUDA Engineer」は、GPU向けの計算を最適化するために、以下の4つのステージでCUDAカーネルを発見・生成・最適化します。

<AI CUDA Engineerの仕組み>

- ステージ1,2:変換と翻訳

- ステージ3:進化的最適化

- ステージ4:イノベーションの保存

ステージ1,2:PyTorchコードをCUDAカーネルに変換・翻訳

ステージ1,2では、AIがPyTorchコード(通常のAIプログラム)を、よりGPUに適したCUDAカーネルに変換し、動作確認を行います。この段階では、性能向上よりも正確な動作が最優先であるため、「GPUで動くか?」をチェックし、次のステージで本格的な高速化が始まります。

ステージ3:進化的最適化により最適なカーネルを作成

次に、「AI CUDA Engineer」は進化的アルゴリズムを活用し、最適なCUDAカーネルを探索・生成します。このプロセスでは、生物の進化にヒントを得た「適者生存」のアプローチを採用し、以下の技術を組み合わせて最適化を進めます。

- ローカルカーネルコード編集:カーネルの微調整を繰り返しながら最適なパフォーマンスを追求

- 交叉カーネル最適化:高性能な既存カーネルを組み合わせて新しいカーネルを生成

- 突然変異:カーネルの一部をランダムに変更し、新たな高速化の可能性を模索

- プロファイリングフィードバック:実際にコードを実行し、速度やメモリ使用量などを評価しながら改良を継続

この最適化プロセスを繰り返すことで、従来の手法では発見できなかった高性能なCUDAカーネルを自動的に生成できます。多くの場合、PyTorchの標準実装よりも10〜100倍の高速化が実現されるそうです。

ステージ4:優れたカーネルをイノベーションとして保存

最後のステージでは、進化的最適化によって発見された最適なCUDAカーネルを、データベース(イノベーションアーカイブ)に保存します。これは、人類の文化的進化と同様に、過去の知見を蓄積し、新たな最適化に活用する仕組みです。

このアーカイブを活用することで、次のような利点があります。

- 新しいAIモデル開発時に、過去に発見された最適なCUDAカーネルを再利用できる

- 異なるタスクにおいて、最適なカーネルの組み合わせを見つけやすくなる

- 最適化プロセスの効率向上により、次世代のCUDAカーネルの発見が加速する

時間が経つほど、蓄積された最適化データが増え、AI CUDA Engineerのパフォーマンスが向上する仕組みとなっています。

AI CUDA Engineerの成果と実績

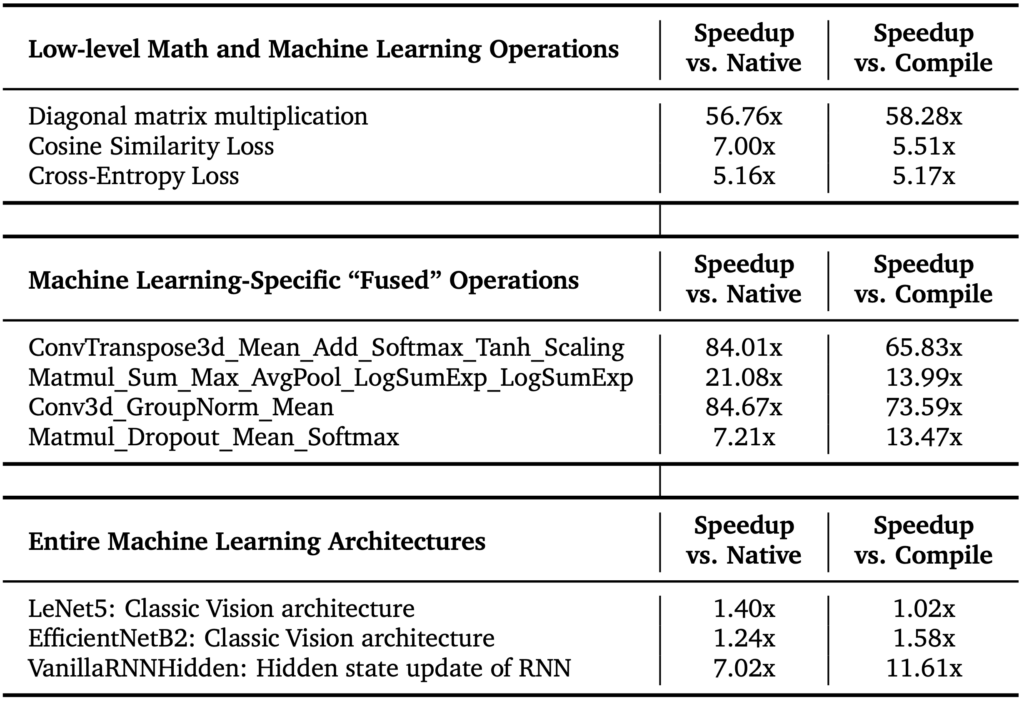

AI CUDA Engineerは、一般的なAI計算を10〜100倍高速化することに成功しました。特に、AIの学習や推論に欠かせない計算(行列積算・畳み込み演算など)が効率化されており、大規模モデルの開発コストが大幅に削減されると期待されています。

さらに、Sakana AIは、この技術によって生成されたCUDAカーネルを公開し、誰もが最適化されたCUDAカーネルを活用できる環境を整えました。これにより、オープンソースAIモデルのパフォーマンス向上が期待されています。

AI CUDA Engineer Archiveの公開

Sakana AIは、この技術によって生成された30000個以上のCUDAカーネルを「AI CUDA Engineer Archive」としてHugging Face上で公開しました。このデータセットは、CC-BY-4.0ライセンスのもとで提供されており、誰でも自由に利用することができます。

このデータセットには以下の情報が含まれています。

- PyTorchのリファレンス実装

- プロファイリングデータ(torch、NCU、Clang-tidyのパフォーマンス指標)

- タスクごとの複数のカーネル(各カーネルの実装詳細)

- エラーメッセージ(カーネルの動作検証に活用可能)

- torch Nativeおよびコンパイル済みランタイムに対する高速化スコア

このデータセットは、研究者や開発者がAIモデルを最適化する際の貴重なリソースとなります。オープンソースAIプロジェクトにおいても、CUDAカーネルの最適化が容易になり、計算コストの削減につながることが期待されています。

AI CUDA Engineerの今後の展望

Sakana AIは「AI技術は100万倍の効率化が可能」と考えており、「AI CUDA Engineer」はその第一歩と位置付けられています。現在のAIはまだ初期段階であり、さらなる最適化が進めば、より少ない計算資源で高度なAIを活用できる未来が実現するでしょう。

AI技術の効率化とエネルギー消費の削減

近年、AIモデルの大規模化が進むにつれ、計算リソースの消費が急増し、それに伴う運用コストやエネルギー消費の増大が大きな課題となっています。特に、大規模言語モデル(LLM)のトレーニングには莫大な電力が必要とされ、環境負荷の増大につながっているのが実情です。

こうした問題に対し、Sakana AIはAIの計算処理を最適化することでエネルギー消費を削減し、持続可能なAI技術の実現を目指しています。これは、「人間の脳は非常にエネルギー効率が高いが、現在のAIモデルは膨大な電力を消費している」という問題意識から生まれた考え方です。

AI CUDA Engineerは、この問題を解決するための重要な技術の1つです。GPUの並列計算を最適化し、計算コストを削減することで、AIモデルのトレーニングや推論時のエネルギー消費を大幅に抑えることができます。Sakana AIのCEOであるデイビッド・ハ氏は、以下のように述べています。

「AIシステムが人間の脳と同じくらい(あるいはそれ以上に)効率的になれない理由はありません。それを実現する最善の方法は、AIを使ってAIをより効率的にすることだと、私たちは信じています。」

この言葉の通り、AI CUDA Engineerの発展により、AI技術の持続可能性が向上し、より多くの企業や研究機関がAIを活用できる時代が到来するでしょう。

まとめ:AI CUDA Engineerがもたらす未来

「AI CUDA Engineer」は、AI技術をAI自身が最適化するという新たなアプローチ を提案する画期的な技術です。これにより、AIモデルの処理速度が飛躍的に向上し、計算コストの削減とエネルギー効率の向上が期待されます。

今後、AI CUDA Engineerがさらに進化すれば、AI技術の普及が加速し、より多くの分野でAIが活用されるようになるでしょう。「AIがAIを最適化する時代」は、すぐそこまで来ています。

Sakana AIの挑戦は、AI業界全体の未来を大きく変える可能性を秘めています。今後の動向にも注目が集まります。